|

|

|

LLM推理优化与部署实战攻略完整版 (图1)

LLM 推理落地实战课程专注于大模型推理的底层逻辑、性能优化及工程部署全链路。这对于技术开发者和AI工程师来说至关重要,特别是在商用核心瓶颈方面,如何在延迟、成本以及部署上找到最优解是关键所在。

LLM推理优化与部署实战攻略完整版 (图2)

此课程不仅填补了多数开发者对于大模型推理落地知识的空白,还提供了全面的技术培训,涵盖量化(如 INT4)、系统加速等方法来降低硬件成本,并提升 GPU 利用率。该课程非常适合那些需要优化推理延迟和成本的专业人员以及希望在 AI 工程领域迅速获得技能的新手。

LLM推理优化与部署实战攻略完整版 (图3)

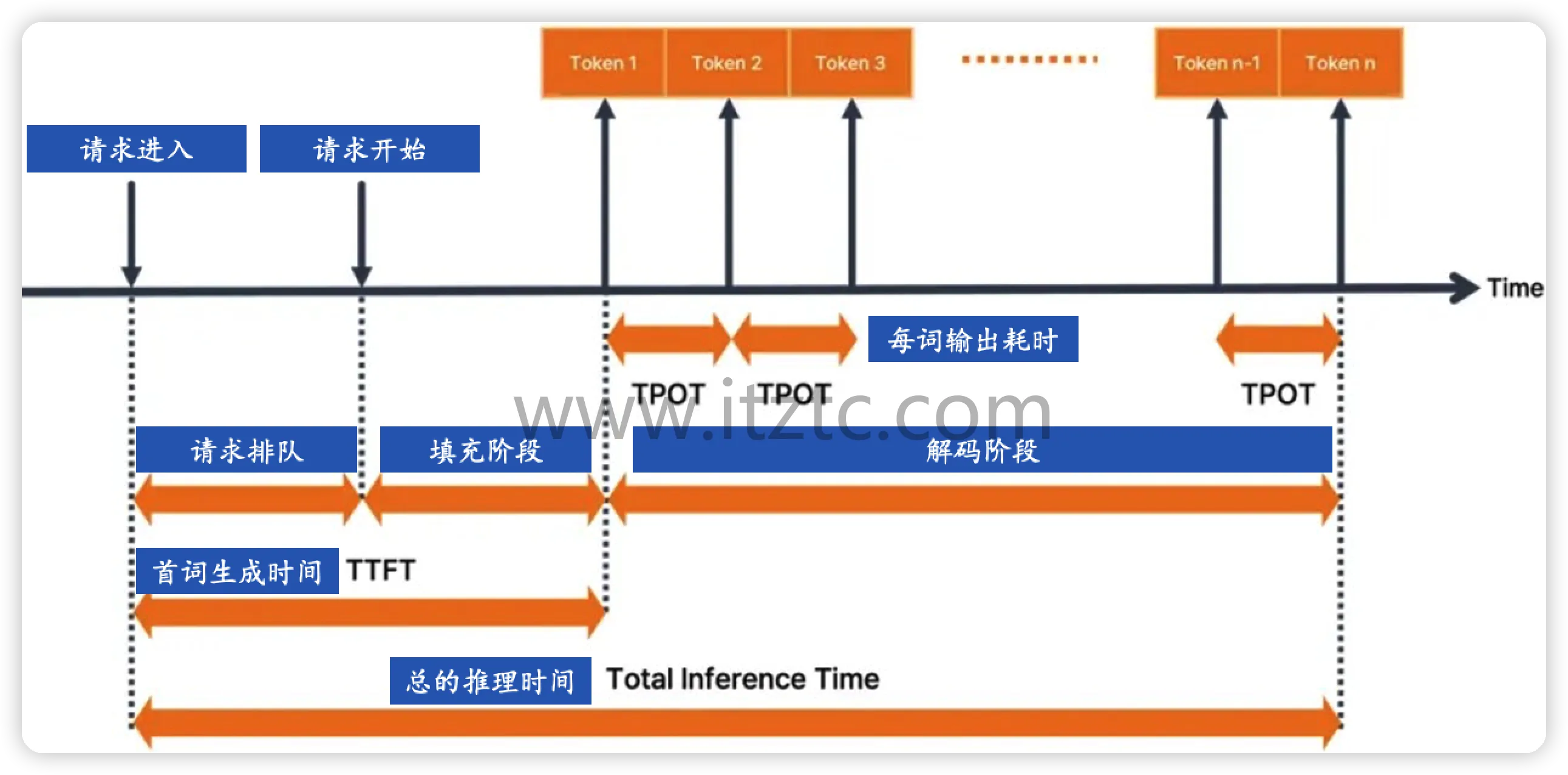

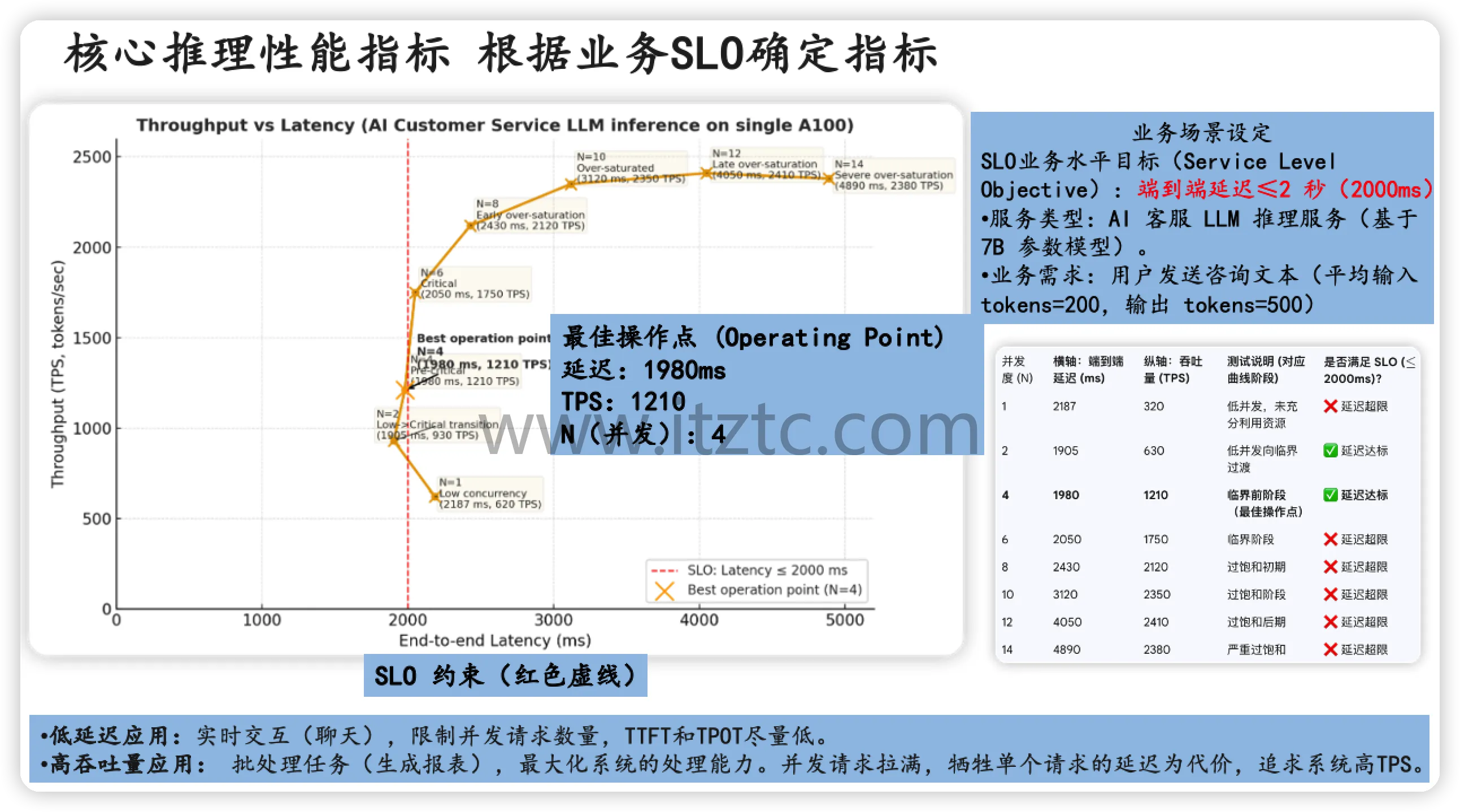

通过本课程的学习,学员可以解决一系列性能痛点问题,例如高TTFT(首次单词传输时间)及每词解码延迟过高的情况。此外,还能有效降低内存使用和硬件成本,确保 GPU 利用率得到显著提升。

LLM推理优化与部署实战攻略完整版 (图4)

该视频教程按五大模块进行覆盖:

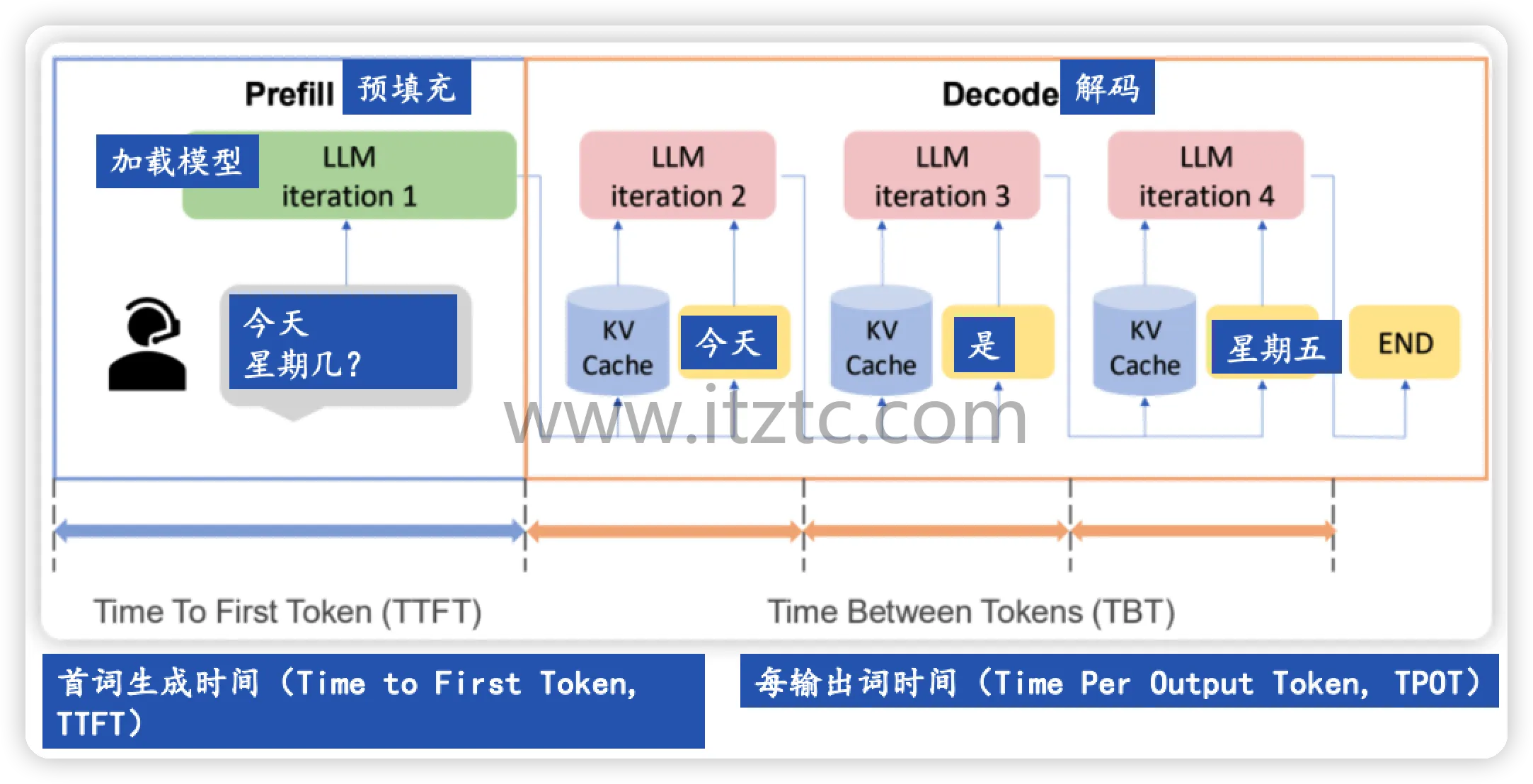

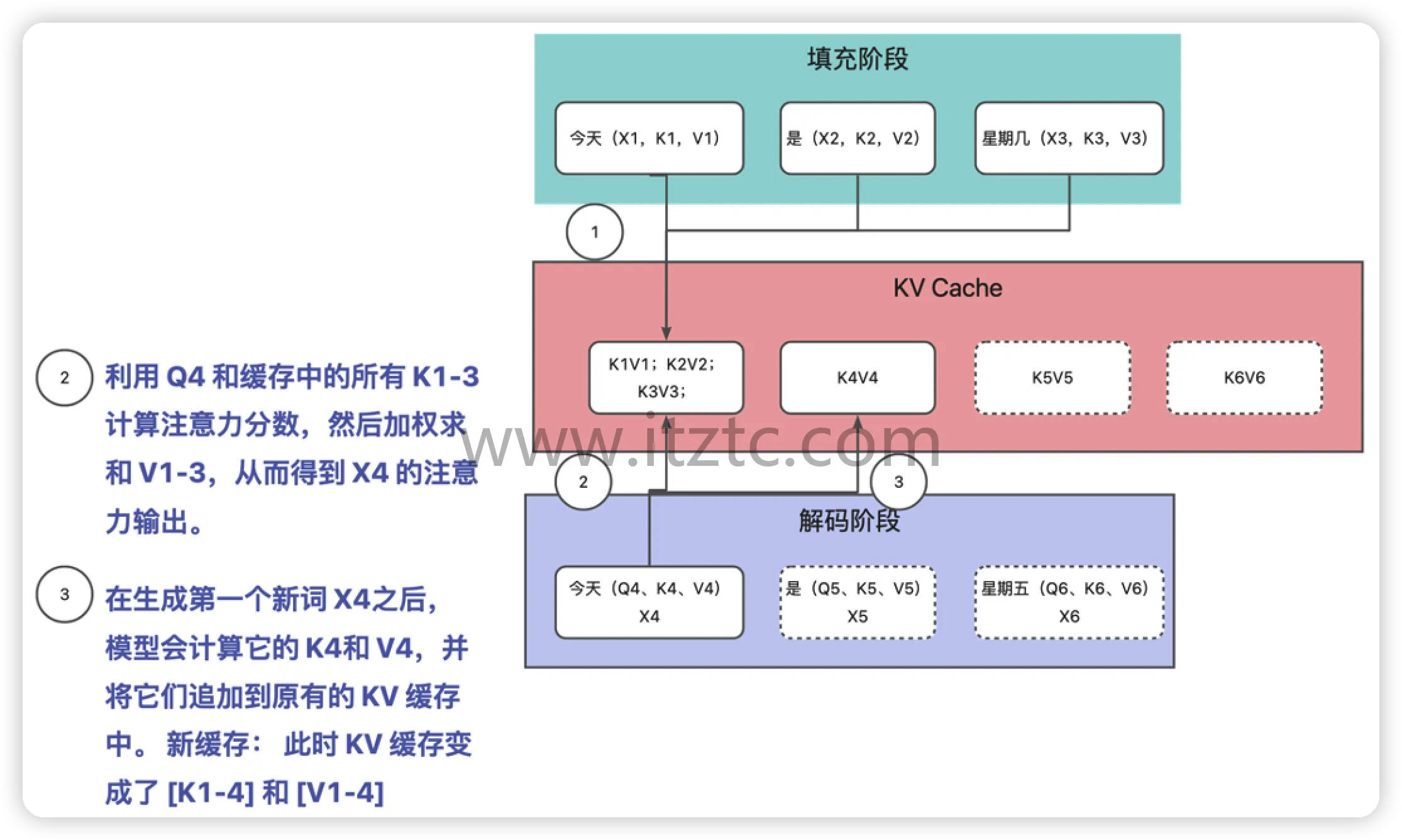

1. 推理基础:涵盖预填充与解码阶段、KVCache 原理及其内存估算。

2. 性能指标评估:介绍TTFT/ITL/TPS 等核心指标定义和业务 SLO 映射。

3. 模型压缩优化:包括AWQ/GPTQ量化、剪枝及知识蒸馏技术的实践应用。

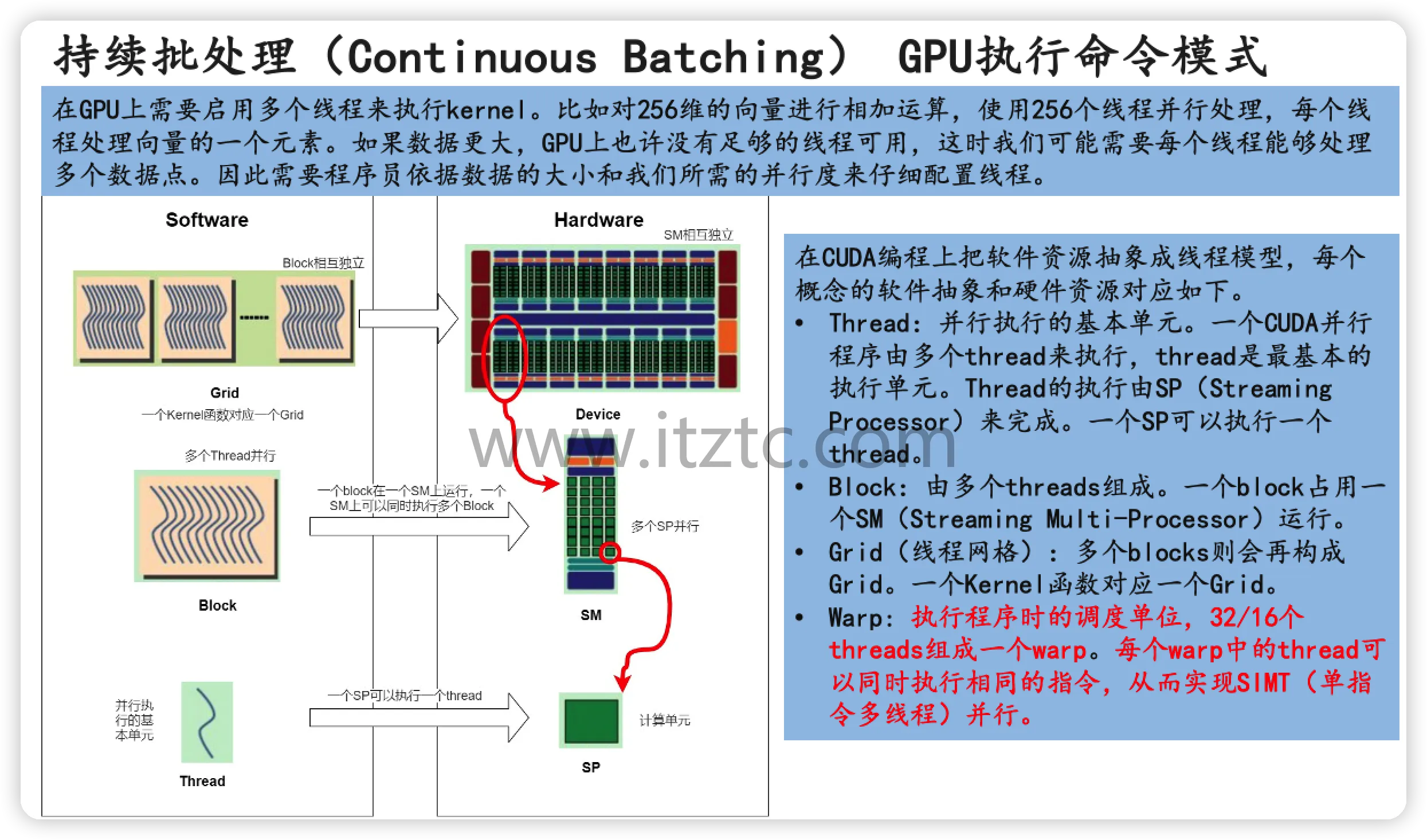

4. 运行时加速:讲解MQA/GQA机制、FlashAttention算子融合与PagedAttention动态内存管理,以及框架选型策略。

5. 部署实战总结:基于具体工作负载制定部署战略,并提供进一步学习方向。

LLM推理优化与部署实战攻略完整版 (图5)

课程特色在于其深入浅出的教学方式和工具化落地方法。每讲都包含理论讲解与实际操作演练,如GPTQ量化工具实践、vLLM 部署演示等。此外,每个优化环节均有实验数据支持,确保结果可量化的准确性。

LLM推理优化与部署实战攻略完整版 (图6)

学完这门课后,学员们能够在职场或项目中灵活应用所学知识,无论是对现有 LLM 服务进行性能调优还是在多模态推理服务上实现高效部署。通过本课程的指导,开发者可以更好地应对各种业务场景下的技术挑战。

📂 资源文件列表

进阶学习场景:

1-1 课程内容介绍.mp4

1-2 LLM推理基础-预填充与解码阶段.mp4

1-3 LLM推理基础-推理阶段与KVCache的关系.mp4

1-4 LLM推理基础-生成KVCache过程推演.mp4

1-5 LLM推理基础-为何需要对KVCache优化.mp4

1-6 LLM推理基础-如何估算模型占用内存.mp4

1-7 LLM推理基础-GPU内部运算原理与推理机制的关系.mp4

1-8 LLM推理基础-列举LLM存储介质以及如何搬运参数.mp4

1-9 LLM推理基础-优化思路-参数量化-运行时加速-IO优化.mp4

1-10 LLM推理基础-章节总结.mp4

1-11 LLM性能指标-内容介绍.mp4

1-12 LLM性能指标-推理评估指标全景图.mp4

1-13 LLM性能指标-首词生成时间.mp4

1-14 LLM性能指标-每词生成时间.mp4

1-15 LLM性能指标-端到端的请求时间.mp4

1-16 LLM性能指标-系统吞吐量TPS.mp4

1-17 LLM性能指标-业务指标SLO.mp4

1-18 LLM性能指标-评测过程与评测工具.mp4

1-19 LLM性能指标-章节总结.mp4

1-20 模型压缩-内容介绍.mp4

1-21 模型压缩-压缩策略-量化-剪枝-蒸馏.mp4

1-22 模型压缩-模型量化-参数存储空间的组成.mp4

1-23 模型压缩-模型量化前后使用的方法AWQ与GPTQ.mp4

1-24 模型压缩-AWQ针对PPL的实验结果.mp4

1-25 模型压缩-AWQ量化过程与实现-.mp4

1-26 模型压缩-GPTQ量化过程以及优化IO策略.mp4

1-27 模型压缩-GPTQ量化工具与实践.mp4

1-28 模型压缩-剪枝分类和过程详解.mp4

1-29 模型压缩-模型蒸馏分类和应用场景.mp4

1-30 模型压缩-章节总结.mp4

1-31 运行时加速方案-内容介绍.mp4

1-32 运行时加速方案-多头注意力机制原理与弊端.mp4

1-33 运行时加速方案-多头注意力计算过程与分析.mp4

1-34 运行时加速方案-MQA与GQA机制以及性能比较.mp4

1-35 运行时加速方案-GPU运算与数据传输分析.mp4

1-36 运行时加速方案-FlashAttention切块和算子.mp4

1-37 运行时加速方案-PagedAttention原理解析.mp4

1-38 运行时加速方案-持续批处理原理解析.mp4

1-39 运行时加速方案-核心推理框架选型.mp4

1-40 运行时加速方案-章节总结.mp4

1-41 推理部署实战指导与总结.mp4

01-vLLM推理实战.docx

2-1 vLLM产品介绍.mp4

2-2 vLLM分布式推理.mp4

2-3 显卡驱动安装与配置.mp4

2-4 Docker进行vLLM模型安装与部署.mp4

2-5 测试vLLM部署的大模型.mp4

2-6 vLLM分布式部署思路.mp4

2-7 系统构建网络配置和框架安装.mp4

2-8 Head和Worker节点配置创建推理集群.mp4

2-9 测试vLLM分布式部署.mp4

02-量化实战-高级.docx

3-1 量化实战-量化目的与结果介绍.mp4

3-2 量化实战-思路与实战步骤讲解.mp4

3-3 量化实战-了解硬件架构量化工具.mp4

3-4 量化实战-安装WSL与Conda.mp4

3-5 TensorRT模型优化器安装与配置.mp4

3-6 NVFP4量化格式.mp4

3-7 模型量化脚本解析与校准数据集.mp4

3-8 模型量化以及结果查看.mp4

3-9 测试量化之后模型查看返回结果.mp4

3-10 介绍EvalScope与Perf命令组成.mp4

3-11 使用EvalScope评测量化模型.mp4

3-12 介绍LLMCompressor量化工具.mp4

3-13 安装LLMCompressor.mp4

3-14 使用LLMCompressor对GPTQ-AWQ-NV.mp4

3-15 针对两种量化工具比较四种量化结果.mp4

3-16 量化实战-课程总结.mp4

《LLM推理优化与部署实战》课件.pptx

|

📥 资源下载

|

|